Moderne Webplattformen mit CMS-, DXP- und Headless-Systemen bieten enorme Flexibilität. Doch in großen Systemlandschaften, die von unterschiedlichen Entwicklerteams und agilen Prozessen geprägt sind, bergen sie auch erhebliche Risiken für die Suchmaschinenoptimierung. Wer hier nicht genau hinschaut, riskiert nicht nur Rankingverluste, sondern auch, dass wertvoller Content von modernen Suchmaschinen, die zunehmend auf generativer KI basieren, nicht richtig erfasst wird.

Themen wie Content-Relevanz und Nutzerintention bleiben zentrale Säulen erfolgreicher SEO-Strategien. In diesem Artikel liegt der Fokus jedoch bewusst auf den technischen Aspekten, die in komplexen Enterprise-Architekturen häufig übersehen werden – und die eine entscheidende Grundlage für nachhaltige Sichtbarkeit in klassischen und KI-basierten Suchsystemen bilden.

Dieser Artikel richtet sich speziell an IT-Manager, SEO-Strategen und Entwickler in Enterprise-Umgebungen, Multisite-Setups und internationalisierten Webpräsenzen. Hier erfahren Sie, welche 7 häufigen Fehler Sie unbedingt vermeiden sollten.

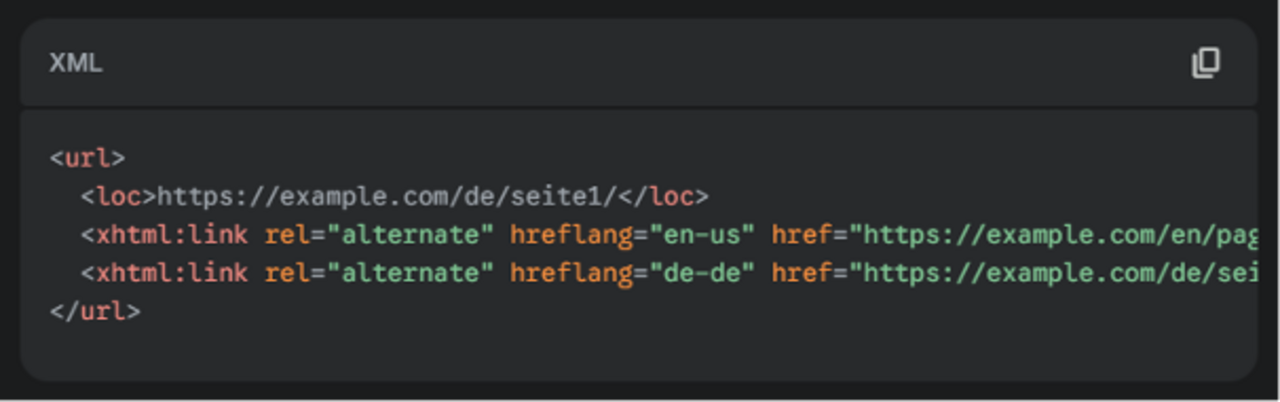

1. Fehlerhafte oder fehlende Internationalisierung (hreflang)

- Das Problem: Fehlerhafte hreflang-Tags verursachen Probleme bei der Auslieferung der korrekten Sprach- und Länderversionen. In großen Multisite-Architekturen sind manuelle Fehler hierbei besonders häufig.

- Die Lösung: Implementieren Sie hreflang-Tags korrekt und umfassend, um Google die richtige Sprachversion zu signalisieren. Für Multisite-Setups ist es oft am effizientesten, die Implementierung zusätzlich in der XML-Sitemap vorzunehmen.

Beispiel (XML-Sitemap-Eintrag):

- Tools und Tipps: Verifizieren Sie die Implementierung mit Tools wie der Google Search Console oder den Audit-Funktionen von Ahrefs und SEMrush, die auf hreflang-Fehler spezialisiert sind.

2. Unsaubere URL-Strukturen

- Das Problem: In großen, dezentralen Teams fehlt oft eine einheitliche Namenskonvention. Dies führt zu unklaren URL-Strukturen mit technischen Parametern (?id=123) oder inkonsistenten Pfaden. Das erschwert Google die Zuordnung relevanter Inhalte und reduziert ihr Rankingpotenzial.

- Die Lösung: Implementieren Sie ein klares und konsistentes URL-Schema, das logisch aufgebaut und für alle Teams verbindlich ist (z.B. /produkte/schuhe/sportschuhe).

- Tools und Tipps: Nutzen Sie Website-Crawler wie Screaming Frog, Sitebulb oder Ryte, um URLs systematisch zu analysieren und Inkonsistenzen zu erkennen.

3. Technische Indexierungshürden bei JavaScript-Rendering

- Das Problem: Bei Headless-Architekturen können Inhalte oft clientseitig gerendert werden. Das führt zu Fehlern bei der Indexierung, wodurch wichtige Details unsichtbar bleiben. Ein sauberer Rendering-Prozess ist nicht nur für Googles Crawler entscheidend, sondern auch, um Ihren Content für generative KI-Modelle zugänglich zu machen.

- Die Lösung: Setzen Sie auf serverseitiges Rendering (SSR) oder Static Site Generation (SSG). SSR ist ideal für hochdynamische Inhalte. SSG eignet sich besser für statische Inhalte wie Marketingseiten oder Blogartikel, da es eine extrem schnelle Auslieferung ermöglicht.

- Tools und Tipps: Prüfen Sie regelmäßig mit der Google Search Console (URL-Prüfung) und Lighthouse-Berichten, ob Ihre Inhalte erfolgreich indexiert werden. Für die Analyse extrem großer Websites eignen sich spezialisierte Crawler wie JetOctopus oder Lumar.

4. Fehlkonfigurierte Robots.txt und Meta-Robots-Tags

- Das Problem: In komplexen Enterprise-Umfeldern, besonders bei großen Relaunches oder agilen Deployments, können sich leicht Fehler in der robots.txt-Datei oder in Meta-Robots-Tags einschleichen, wenn es an klaren QA-Prozessen fehlt. Dies kann wichtige Seiten versehentlich blockieren.

- Die Lösung: Führen Sie regelmäßige SEO-Audits durch und implementieren Sie eine verbindliche Checkliste, die vor jedem Deployment die Robots-Einstellungen prüft.

- Tools und Tipps: Nutzen Sie spezialisierte Tools für kontinuierliches Monitoring wie ContentKing, um Änderungen sofort zu erkennen. Klassische Crawler wie Screaming Frog oder die Audit-Funktionen von Sistrix eignen sich für punktuelle Prüfungen.

5. Duplicate Content durch fehlende Canonical Tags

- Das Problem: In internationalen Umgebungen mit mehreren Content-Quellen tritt Duplicate Content häufig auf, wenn dieselben Inhalte in mehreren Regionalversionen ohne Canonical-Tags verwendet werden. Dies verwässert das Ranking, da Google die primäre Quelle nicht erkennt.

- Die Lösung: Nutzen Sie konsequent das Canonical-Tag, um auf die Originalquelle zu verweisen. Etablieren Sie Canonical-Checks als Teil Ihres Content-Management-Workflows.

- Beispiel: <link rel="canonical" href="https://www.ihredomain.de/originalseite"/>

- Tools und Tipps: Identifizieren Sie potenzielle Duplikate regelmäßig mit Plattformen wie Ahrefs, Sistrix oder SEMrush, deren Site-Audit-Funktionen dies detailliert aufzeigen.

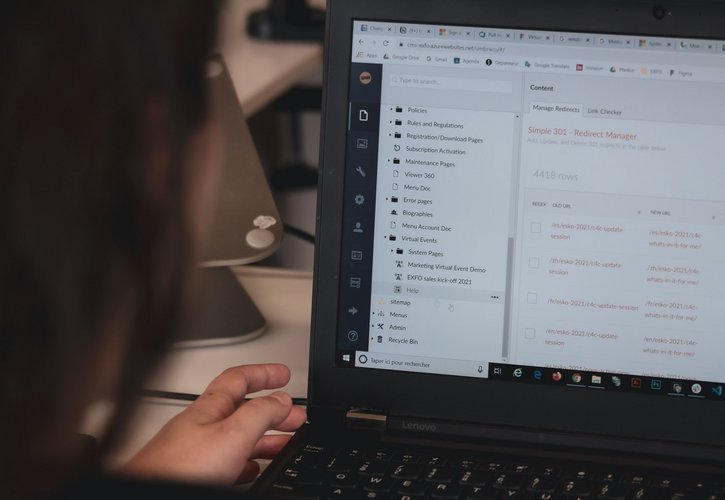

6. Fehlende oder mangelhafte Weiterleitungen (301 Redirects)

- Das Problem: Bei Migrationen gehen häufig URL-Strukturen verloren. Ohne einen klaren Prozess für die Erstellung von Redirect-Maps landen Nutzer und Suchmaschinen auf Fehlerseiten.

- Die Lösung: Erstellen Sie umfassende Redirect-Maps (alte URLs zu neuen URLs) und testen Sie diese gründlich vor und nach der Migration.

- Tools und Tipps: Verifizieren Sie die Weiterleitungen unmittelbar nach der Migration mit Crawlern wie Screaming Frog oder Sitebulb. Für die fortlaufende Überwachung ist ContentKing ideal, um Broken Links oder Redirect-Ketten zu entdecken.

7. Schwache interne Verlinkung

- Das Problem: In großen, automatisierten Content-Umgebungen entstehen oft unzureichende interne Verlinkungen. Dadurch können wichtige Inhalte für Google nicht als relevant erkannt werden. Eine systematische Verlinkung hilft nicht nur Google, sondern auch generativen KI-Modellen, die Relevanz Ihrer Inhalte besser zu kontextualisieren.

- Die Lösung: Etablieren Sie systematische interne Verlinkungskonzepte. Sorgen Sie dafür, dass redaktionelle oder technische Systeme strategische Verlinkungen auf wichtige Inhalte vorsehen.

- Tools und Tipps: Prüfen Sie regelmäßig die Qualität der internen Verlinkung mit spezialisierten Audit-Tools wie Lumar oder All-in-One-Plattformen wie Ahrefs oder SEMrush.

SEO-Checkliste für Relaunches und Deployments

Pre-Launch-Check (Vor dem Relaunch)

- Kritisch: robots.txt und Meta-Robots-Tags auf korrekte Einstellungen prüfen.

- Kritisch: Vollständige und fehlerfreie Redirect-Maps erstellen und testen.

- Kritisch: URL-Struktur auf Konsistenz und Lesbarkeit überprüfen.

- Empfohlen: Interne Verlinkungskonzepte auf strategische Relevanz prüfen.

- Empfohlen: Canonical-Tags und hreflang-Tags stichprobenartig auf Korrektheit überprüfen.

Post-Launch-Check (Nach dem Relaunch)

- Kritisch: Crawl-Berichte (Google Search Console) auf Indexierungsfehler und 404-Seiten überwachen.

- Kritisch: Redirect-Ketten und fehlende Weiterleitungen mit Crawlern prüfen.

- Empfohlen: Rendering-Status von JavaScript-Inhalten mit der Google Search Console und Lighthouse prüfen.

- Empfohlen: Interne Verlinkung und Canonical-Tags systematisch auf Fehler überwachen.

- Empfohlen: Sichtbarkeit und Traffic der wichtigsten Seiten monitoren.

Fazit: Inhalt und Technik im Einklang

Eine technisch saubere SEO-Grundlage ist essenziell – besonders in komplexen Enterprise-Architekturen. Die Vermeidung dieser sieben typischen Fehler legt nicht nur das Fundament für nachhaltige Rankings und optimale Sichtbarkeit in der klassischen Suche. Sie ist auch Voraussetzung dafür, dass Inhalte im Kontext der Generative Engine Optimization (GEO) zuverlässig erkannt, verarbeitet und ausgespielt werden können.

Dabei gilt: Nur wenn technische Struktur und inhaltliche Relevanz zusammenspielen, entsteht langfristiger Erfolg. Die sauberste Architektur nützt wenig, wenn der Inhalt austauschbar bleibt – ebenso wie relevanter Content verpufft, wenn er durch technische Hürden unsichtbar bleibt. Beides gehört zusammen – besonders in einem Suchumfeld, das zunehmend von KI geprägt ist.

Sprechen Sie uns an