Wann Big Data im Forderungsmanagement sinnvoll ist

Ob Analyseverfahren für ein Unternehmen sinnvolle Ergebnisse bringen, kann nicht pauschal beantwortet werden. Wer sich aufmacht, den Datenschatz des eigenen Unternehmens zu heben, sollte aber vor dem ersten Spatenstich folgende Fragen mit einem Ja beantworten: Speist sich der Bestand aus einer Vielzahl heterogener Daten? Ist die Reaktionsgeschwindigkeit bei der derzeitigen Analyse zu gering? Besteht hoher Zeitdruck bei der Einführung neuer KPIs und Methoden? Und gibt es überhaupt eine grundsätzliche Bereitschaft, datengesteuerte Prozesse umzusetzen?

Auch wenn diese Kriterien erfüllt sind, ist für den konkreten Einzelfall zu prüfen, inwiefern es sinnvoll ist, sich mit neuen Methoden auf das unbekannte Terrain vorzuwagen. Deshalb sollte zu Beginn einer Big-Data-Analyse ein Pre-Test stehen. Dort entwickeln Datenspezialisten gemeinsam mit Fachleuten aus dem Unternehmen Ziele und mögliche Fragen. Auf dieser Basis wird dann die Qualität und Eignung der Datenstrukturen anhand ausgewählter Datensätze des Unternehmens getestet und die Ergebnisse explorativ ausgewertet und diskutiert. Kommen die Beteiligten hier zu einem positiven Fazit, wird die Analyse ausgeweitet. Die Erfahrungen von Neofonie bei Big-Data-Analysen haben gezeigt, dass gerade die explorative Zusammenarbeit von Analysten auf Unternehmensseite mit den externen Informatikern unabdingbare Voraussetzung ist, um die Analyseergebnisse bewerten und sinnvolle Rückschlüsse für das Business ziehen zu können.

Im Erfolgsfall liegen nach der Implementierung eines Big-Data-Systems quantifizierte Daten für eine KPI-Steuerung vor. Beispielsweise weiß das Unternehmen dann nicht nur, welche Prozessschritte im Call Center im konkreten Fall am erfolgversprechendsten sind, sondern auch, wie hoch die Wahrscheinlichkeit ist, dass ein einzelner Prozessschritt – etwa ein zusätzlicher Anruf beim Kunden – zur Zahlung führt.

Mit welchen konkreten Anwendungsfällen können Unternehmen die Potenziale durch Big Data ausschöpfen?

Wie immer, wenn eine disruptive Technologie wie Big Data auf den Markt kommt, gibt es die „Early Adopter“ und die „Late Mover“. So ein einheitliches Bild wie vor zwei Jahren (als viele noch nichts von Big Data gehört hatten oder die ersten Schritte starteten) lässt sich heute nicht mehr zeichnen. Im Markt existieren eine ganze Reihe von unterschiedlichen Big Data Reifegraden. Unternehmen, die auf Basis von Big Data völlig neue Geschäftsmodelle, Produkte und Services entwerfen, bis hin zu Unternehmen, die gerade erst anfangen, eine grundsätzliche Potenzialabschätzung zu entwickeln. Big Data ist in aller Munde und fast jeder will „irgendwie“ mitmischen. Unternehmen, die heute noch orientierungslos sind, werden im Zeitalter der Data-Economy auf mittel- bis langfristige Sicht verdrängt werden.

Ziel von Big Data ist das Aufdecken von neuen Potenzialen und das Heben von vorhandenen „Daten-Schätzen“ und das oft in neuen Kontexten. Wie massiv und erfolgreich Big Data das bestehende Geschäft von Unternehmen digital transformieren kann, zeigen drei Beispiele:

Onlineshops stellen im Mittel 30% Umsatzwachstum durch auf Big Data basierende Recommendations fest (ein klassisches Big Data & Maschine Learning Thema); Banken bewerten heute die Risiken von Wertpapier-Portfolios in Echtzeit durch semantische Text-Analyse von Nachrichtenströmen und nutzen Social Media Monitoring für Scoring Verfahren; Verlage wie die New York Times nutzen Datenjournalismus, um Lesern “Live Experience” zu bieten und gleichzeitig neue Umsatzquellen zu erschliessen.

Wie stellen Unternehmen überhaupt fest, dass sich die intelligente und automatisierte Nutzung der eigenen Daten für sie lohnt?

Um eine Potenzialanalyse durchführen zu können, ist grundsätzliche die Kenntnis über die unternehmensspezifischen „Datenschätze“ und die Formulierung der „richtigen Fragen“ bzw. Anwendungsfälle nötig. Die explorative und flexible Methodik von Big Data ist bestens geeignet, um Anwendungsfälle schnell und kostengünstig zu bestätigen, anzupassen oder zu verwerfen – unabhängig der Branche oder Unternehmensgröße. Die Anwendungsfälle können dabei relativ einfach oder eben komplex ausfallen. Nutze ich vorhandene Daten oder neue Daten? Optimiere ich das bestehende Business oder baue ich neue Geschäftsmodelle auf? Der vermutlich einfachste Einstieg in die Welt der agilen Datenanalyse beginnt mit der Frage, wie mit den vorhandenen Daten das bestehende Business optimiert werden kann.

Ein aktuelles Beispiel aus der Praxis: Die gesamte Verlagsbranche steht vor einem massiven Wandel. Inflationärer Content im Web und die abnehmende Datenjournalismus-Zahlungsbereitschaft der Leser macht den Verlagen zu schaffen. Die Umsätze sinken. In Folge werden Redaktionen häufig massiv verkleinert. Als ein möglicher Ausweg aus dem Teufelskreis wird in jüngster Zeit verstärkt “Data Driven Journalismus” diskutiert und von führenden Verlagshäusern bereits erfolgreich praktiziert. Der “Use Case” dahinter ist einfach: Verlage sitzen auf umfangreichen redaktionellen Inhalten und Daten. Mit Hilfe von Big Data werden die Inhalte strukturiert und analysiert. Der Redakteur stellt die Fragen auf seinem “Big Data Dashboard” und produziert im Ergebnis ansprechende, interaktive und mehrwertschaffende Visualisierungen, wodurch das Verlangen der Leser nach “Live Experience” einerseits und “Mobile Experience” andererseits befriedigt wird. Der Leser erhält dadurch einen Mehrwert, für den er zu bezahlen bereit ist. Gleichzeitig können Redaktionen ihre Effizienz erheblich steigern.

Wie sollten sich Unternehmen in einem allerersten Schritt an das Thema Big Data heranwagen?

Der Use Case ist immer zuerst da, die genauen Anforderungen und die Ausgestaltung der Big Data Analyselösung ergeben sich erst im Laufe der Zeit. Das Neue an Big Data ist, dass mit der Lösung sehr kostengünstig und schnell gestartet werden kann und diese dann agil und explorativ an die Notwendigkeiten angepasst wird. Hier kommen die Stärken von Big Data Frameworks in Hinblick auf Skalierbarkeit der Speichervolumina und Rechengeschwindigkeit zum Tragen. Durch das agile Vorgehen ergeben sich im Laufe eines Big Data Projektes immer wieder Breakpoints, zu denen die Wirtschaftlichkeit der Lösung überprüft werden kann. Das schützt Entscheider vor dem Risiko großer Fehlinvestitionen. Gleichzeitig liegen an jedem Breakpoint neue Erkenntnisse vor, die bei der Definition von Zielen für die Gesamtlösung neue Impulse geben und so als Basis für die nächste Ausbaustufe dienen.

Ein weiterer Grund, dass die Lösung in den Hintergrund tritt, sind die exzellenten Cloud-Möglichkeiten von Big Data. Eine Lösung kann von einem passenden Dienstleister gemietet werden und so direkt am „Day 1“ eines Big Data Projektes verfügbar sein. Pay-as-you-Go SaaS-Lösungen ermöglichen so die Fokussierung auf den Use Case.

Big Data Anwendungsfälle reichen von:

effizienteren Unternehmensprozessen und

strategischem Marketing über

Verbesserung der Produkte/Services bis hin zur

Identifizierung neuer Geschäftsmodelle.

Doch wie identifiziert man hier sinnvolle Use Cases?

Um die sinnvollen Use Cases zu identifizieren, sind vor allem zwei Abläufe zu untersuchen: Die Wertschöpfungskette meines Unternehmens und die Customer Journey meiner Kunden.

Bei der Analyse der Wertschöpfungskette stehen die Aspekte der Automatisierung und die Leistungen, bzw. Produkte des Unternehmens im Brennpunkt. Unter dem Big Data Gesichtspunkt sind daher die folgenden fünf Fragen zu untersuchen:

Wie sieht die Wertschöpfungskette meines Unternehmens aus?

An welchen Stellen der Wertschöpfungskette ersetze ich heute schon menschliche Intelligenz durch Maschinen bzw. an welchen Stellen kann ich das zukünftig tun?

An diesen Stellen: Welche Daten (unternehmensinterne und unternehmensexterne) liegen heute bereits vor, die eine Erkenntnis oder Entscheidungsfindung an diesen Punkten beeinflussen? Welche zusätzlichen Daten kann ich intern oder extern noch hinzufügen, um die Basis für Entscheidungsfindungen noch zu erweitern?

Welche zusätzlichen Algorithmen (z.B. Maschine Learning, Natural Language Processing oder Statistik) können den Erkenntnis- und Entscheidungsprozess zusätzlich unterstützen?

Big Data heißt sehr oft Geschwindigkeitsgewinn bis hin zur Echtzeit. Wie beeinflusst diese Beschleunigung jeden einzelnen Schritt?

Die Customer Journey ist dabei ein zentraler Aspekt, denn immer wenn der Endkunde bessere Leistungen und Produkte erhält oder bessere Services genießt, steigert das direkt den Wert der angebotenen Waren und Services. Dabei hilft eine serviceorientierte Sichtweise, um neue Leistungen und Geschäftsfelder zu identifizieren, d.h. den Blick dafür, wie das Unternehmen zusätzliche Dienste für seine Kunden zur Verfügung stellen kann. Die Erstellung von detaillierten Nutzerprofilen wird dabei immer wichtiger, um ein personalisiertes Erlebnis zu schaffen und kaufwillige Nutzer zu identifizieren.

Ein zusätzlicher Blick über den Tellerrand hat aber noch nie geschadet. Hier hilft es, erfolgreiche neue Geschäftsmodelle anderer Anbieter zu analysieren und zu bewerten, in wie weit das bisherige Geschäft an die neuen Marktgegebenheiten angepasst werden muss.

Nach welchen Kriterien bewertet man, ob die identifizierten Use Cases erfolgversprechend sind?

Allgemein ist der zentrale Gesichtspunkt die leichte Zugänglichkeit der Daten. Komme ich an alle notwendigen Daten im Unternehmen leicht heran und wenn ja, wie bekomme ich sie in meinen Big Data Cluster? Welche Daten muss ich von Dritten zukaufen (z.B. Wetter, Nachrichten, Scoring-Daten) und was kostet das? Welche Daten erhebe ich bisher nicht, möchte ich aber zusätzlich noch erheben? Hier erlebt man in der Praxis oft unangenehme Überraschungen.

Danach erfolgt die Bewertung hinsichtlich Gesamtkosten (Lösung + Daten + Betrieb) und der Chancen hinsichtlich Mehr- und Zusatz-Umsatz. KPIs und Dashboards sind und bleiben dabei die zentralen Werkzeuge. In der Regel liefern alle Big Data Lösungen im Betrieb eine Vielzahl an neuen KPIs, mit denen sich der Erfolg einer Lösung sehr schnell bewerten lässt.

Welche Analysetools bieten einen einfachen Einstieg in Big Data Lösung?

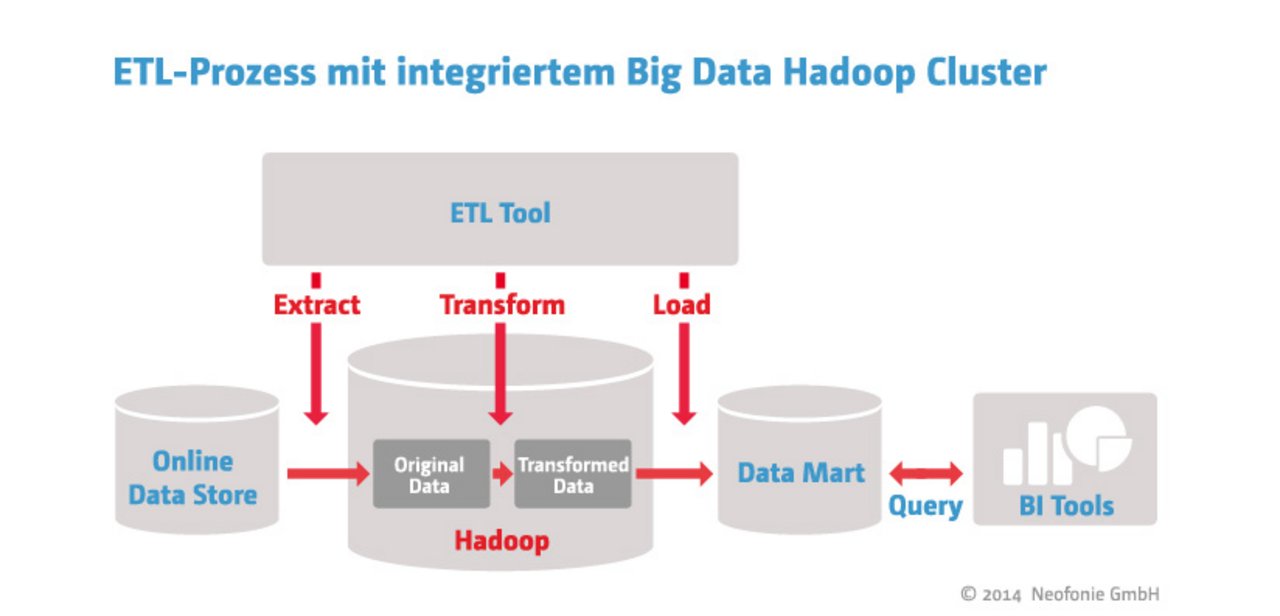

Apache Hadoop ist eine ideale generische Basis und guter Einstieg in Big Data, mit der man nichts falsch macht. Gleichzeitig gilt es das Augenmerk auf eine dazu passende ETL (Extract Transform Load) Lösung zu legen, denn irgendwie müssen die Daten ja in die Big Data Lösung hinein. Unser Technologiepartner Talend beispielsweise bietet als einer der Big Data Marktführer einen schnellen und einfachen Einstieg auf Basis einer Cloud- oder Sandbox-Lösung. Insbesondere die (vorkonfigurierten) Sandbox-Lösungen sind hier gerade stark im Kommen. Gleichzeitig sollte man sich von Anfang an einen Big Data Experten ins Haus holen, der bei den ersten Schwimmversuchen hilft und bei der Analyse und Identifikation der vielversprechendsten Use Cases unterstützt. Das spart auf lange Sicht Zeit und Geld und minimiert das Investitionsrisiko. In unserer Aufzeichnung des Webinars „Machen Sie es richtig, in Echtzeit mit Apache SPARK, zeigen wir Ihnen anhand von Anwendungsszenarien, warum sich der Einstieg in SPARK lohnt.“

Veröffentlichung am 28. August 2014, aktualisiert am 14. Oktober 2020

Bildquelle: unsplash, NASA